cze 3, 2025

Rozwój oprogramowania – od pomysłu do gotowego produktu z software house

W tym artykule pokażę Ci, jak wygląda proces rozwoju oprogramowania z perspektywy współpracy z software house – od pierwszego szkicu...

-

lip 16, 2019

Świat pędzi i nieustannie się zmienia. Firmy borykają się z tym, aby nadążyć za zmianą, aby być lepszym względem konkurencji i osiągać coraz lepsze wyniki finansowe. Nie jest to łatwe zadanie, zwłaszcza w perspektywie nowych potrzeb, które rodzą się w procesie zmiany. Świadomość firmy, jej pozycji na rynku i otoczenia, jest jednym z wielu czynników, które mają realny wpływ na to, czy firma odnajdzie się w nowej, zmienionej rzeczywistości. Wiarygodne dane, umiejętne ich wykorzystanie, analiza i prezentacja są niezbędne przy podejmowaniu właściwych decyzji biznesowych. W obliczu ilości gromadzonych informacji, tempa ich przetwarzania oraz różnorodności danych, perspektywa dostarczenia rzetelnej analizy, nie jest oczywista i wiąże się z wieloma wyzwaniami. Jakie trudności niesie za sobą proces przygotowania danych do analizy oraz jak sobie z nimi poradzić?

Wyzwań związanych z przygotowaniem danych do analizy może być wiele i mogą być one różnie kategoryzowane. Podstawową kwestią jest wielkość zbioru, na którym pracujemy. Jaka jest jednak definicja dużego zbioru? Dla jednej osoby praca z arkuszem kalkulacyjnym i milionem rekordów będzie już dużym zbiorem, dla innego użytkownika ta sama próbka miliona rekordów, będzie jedynie „przystawką”. Czym jest zatem Big Data? Termin ten jest trudny do określenia. Przyjmuje się, że jeśli ogólnodostępne narzędzia są niewystarczające, aby przetworzyć duży zbiór danych, a dodatkowo towarzyszy temu stała potrzeba zdobywania nowych informacji lub wiedzy, to mamy wówczas do czynienia z Big Datą. Dobrym przykładem, gdzie ewidentnie mamy do czynienia z Big Datą jest rynek telekomunikacyjny. Ciągła potrzeba rejestrowania połączeń abonentów definiuje wielkość bazy danych. Analityk, który chce pracować na tak dużej bazie, musi posiadać odpowiednie narzędzia i kompetencje. Rynek telekomunikacyjny jest dynamiczny, szybko się zmienia i towarzyszy temu stała i silna potrzeba zdobywania nowych informacji o Kliencie np. badania jego preferencji.

Aby analiza danych była przeprowadzona w sposób efektywny i dostarczała rzetelne informacje, dobrze jest wcześniej odpowiednio przygotować się do prac analitycznych.

Punktem wyjścia jest źródło danych. Niezależnie od tego, czy będziemy pracować na dużym, czy małym zbiorze, należy dołożyć wszelkich starań, aby doprowadzić źródło danych do stanu idealnego. Jakość danych jest krytycznym punktem w całym procesie, a praca nad nią sprowadza się do mniej lub bardziej zaawansowanych działań. Dane niekompletne, zdublowane, nieaktualne, bądź w jakikolwiek inny sposób naznaczone błędem, będą wypaczać obraz rzeczywistości i wpływać na właściwe podejmowanie decyzji biznesowych. Dlatego też ważne jest, aby prace nad jakością danych zacząć już od najwcześniejszego etapu – zbierania danych. Specyfika i skala gromadzonych danych będzie w dużym stopniu definiować rodzaj bazy danych. Dla przykładu, osoba, która prowadzi sklep z pieczywem, prawdopodobnie będzie w stanie określić listę produktów, wielkość sprzedaży i koszty w prostej tabeli i na podstawie, tylko jednego źródła danych będzie w stanie określić większość wskaźników biznesowych. Inaczej sytuacja będzie się kształtować w przypadku dużej firmy, która aby określić te same parametry, prawdopodobnie będzie już musiała zastosować bardziej zaawansowany model np. relacyjnej bazy danych, gdzie dane przechowywane są w wielu tabelach. W przypadku zastosowania takiego rozwiązania, istotne jest to, aby w każdej tabeli był identyfikator, który umożliwi połączenie ze sobą konkretnych tabel i pracę na zbiorze tylko z danymi, które będą istotne z punktu widzenia realizowanej analizy. Rejestrowanie danych, powinno odbywać się w sposób skrupulatny, ustrukturyzowany i sformatowany. To jak bardzo zaangażujemy się w prace związane z dostosowaniem tabel, zaprocentuje na późniejszym etapie prac raportowo-analitycznych.

Duże firmy dysponują wielkimi wewnętrznymi zbiorami danych (hurtowniami danych), ale aby zaspokoić w pełni swoje potrzeby analityczne, często posiłkują się dodatkowymi, zewnętrznymi bazami danych. Niezależnie od pochodzenia źródła danych, im większa ilość źródeł, (zwłaszcza tych zewnętrznych) tym trudniej wyciągnąć istotne informacje i przygotować analizę.

Obsesja na punkcie jakości danych powinna nam towarzyszyć na każdym etapie prac nad analizą. O potrzebie utrzymania wysokiej jakości danych, była mowa już na etapie gromadzenia informacji i ta sama potrzeba, definiuje kolejny etap – przygotowania danych. Z perspektywy końcowego odbiorcy analizy, ten etap prac jest często niedoceniany i niewidoczny. Perspektywa analityka będzie zupełnie inna. Przygotowanie danych to etap wymagający, często czasochłonny i nużący, ponieważ sprowadza się do oczyszczania, dostosowania i uzupełniania danych. Surowe informacje, które pochodzą często z różnych źródeł, nie nadają się zwykle do zaprezentowania wprost odbiorcy analizy. Dane zawierają błędy lub są niepełne. Często jest tak (zwłaszcza w Big Data), że aby zaprezentować dane analityczne w sposób zrozumiały dla końcowego odbiorcy, analityk musi utrzymać dodatkowe słowniki, które przełożą posiadane dane, na język zrozumiały dla odbiorcy analizy. Biorąc pod uwagę różne potrzeby i definicje biznesowe, analityk na tym etapie musi również dostosować źródło, nakładając na nie, dodatkowe reguły biznesowe. Co to oznacza? W dużej, ustrukturyzowanej organizacji ta sama sprzedaż (np. w branży ubezpieczeń, sprzedaż polisy na życie) może być inaczej rozpoznana, w zależności od przypisanej w strukturze osobowej roli. Ta sama sprzedaż polisy dla agenta ubezpieczeniowego, którego podpis widnieje na umowie, może być inaczej zaliczona niż dla managera tego agenta. Wszelkiego rodzaju tego typu zależności dobrze, aby były już odzwierciedlone na etapie prac dostosowania źródła danych do analizy biznesowej.

Zweryfikowane i dostosowane do odpowiedniego formatu dane gotowe są do załadowania. Ładowanie danych to etap, w którym przekształcamy dane na język zrozumiały dla maszyny (komputera). Większość danych musi mieć zachowaną formalną i ścisłą składnie. Ładowanie danych, zwłaszcza w kontekście Big Data, to proces czasochłonny, ponieważ sprowadza się do rozbicia złożonych, ale czytelnych dla człowieka danych, na język binarny. W przypadku ładowania dużych partii danych dodatkowym wyzwaniem jest sprzęt, który musi mieć dużą moc obliczeniową.

Zakończony sukcesem etap ładowania danych najczęściej jest początkiem kolejnego etapu, czyli etapu przetwarzania. Przetwarzanie danych jest wtedy, kiedy nasze źródło poddawane jest procesowi manipulacji, poprzez różnego typu działania. Działania te pośrednio dyktowane są przez zleceniodawcę analizy. Dla przykładu, analityk ma za zadanie przygotowanie analizy sprzedaży dla konkretnego okresu. Analiza ma pokazać realizację sprzedaży w zestawieniu z budżetem, a także wskazać pięć najlepszych regionów sprzedaży. Przy pracy nad taką analizą zachodzi potrzeba przeprowadzenia różnego rodzaju operacji, między innymi: zredukowania danych tylko do wskazanego okresu, kalkulacji wartości sprzedaży i porównanie jej z budżetem, zestawienie struktury regionów, sortowania i grupowania najlepszych z nich. Dla maszyny, wskazane w przykładzie operacje, to nic innego jak zestaw instrukcji, które musi wykonać w kolejnych krokach. Stopień trudności będzie uzależniony miedzy innymi od: ilości zapytań, wielkości i ilości źródeł danych, od sprzętu i oprogramowania jakim dysponujemy. Zrealizowanie wszystkich punktów z instrukcji i wygenerowanie raportu, o który wnioskował zleceniodawca oznacza płynne przejście do kolejnego etapu, czyli do właściwej analizy.

Analiza danych sprowadza się do wyciągnięcia wniosków i przedstawienia rekomendacji dla biznesu. Wyzwaniem w tym zakresie stanowią kompetencje i zdolności analityczne osoby, realizującej te zadanie. W zależności o specyfiki problemu, analizy może dokonać każda osoba będąca w posiadaniu raportu. W przypadku mocno zaawansowanych zagadnień, często zwłaszcza duże firmy posiłkują się ekspertami z zewnątrz (bo nie identyfikują wystarczających kompetencji analitycznych wewnątrz firmy).

Wyzwania w zakresie ostatniego elementu w procesie dostarczania analizy związane są z przechowywaniem danych. Ten etap sprowadza się nie tylko do archiwizowania gotowego raportu, czy analizy, ale do przechowywania wszelkich informacji z każdego wcześniejszego etapu tj. źródeł danych, kwerend, instrukcji, które mogą być jeszcze wykorzystane w przyszłości i które przyczynią się do szybszego dotarcia do wiedzy. Nie jest to łatwe zadanie, zwłaszcza w obecnych czasach, kiedy coraz więcej firm ociera się o wolumen danych z przedziału Big Data. Wiele firm kreuje trendy na podstawie historycznych danych, dlatego też właściwe przechowywanie danych, jest kluczowe z punktu widzenia prowadzonych przez nich działalności. Wyzwaniem w tym zakresie może być również bezpieczeństwo. Każda poważna firma, czy instytucja kładzie ogromny nacisk na to, aby posiadane przez nich bazy danych przetrzymywane były w sposób bezpieczny. Kluczowe źródła danych mają zawsze kopię zapasową. Do produkcyjnych źródeł danych mają dostęp tylko i wyłącznie uprawnione osoby, uprawnienia pozwalające na modyfikację danych w generycznych źródłach, ograniczane są do minimum. Dane zawsze zabezpieczone są przed ewentualnymi atakami hakerów z zewnątrz.

Każdy analityk dałby wiele za receptę na idealną analizę. W literaturze lub w sieci możemy znaleźć wiele podpowiedzi w jaki sposób pracować z danymi lub jak nimi zarządzać, aby analiza była dobra. Niestety nikt nie da nam gwarancji na to, że stosując się do znalezionych tam zapisów, nasza analiza będzie zawierała pełne dane i będzie wartościowa z perspektywy osoby, która będzie podejmować na jej podstawie decyzje biznesowe. Znamy już wyznania jakie niesie za sobą proces związany z przygotowaniem danych do analizy. W jaki sposób poradzić sobie z tymi trudnościami?

Dbałość o jakość danych, w tym tekście już kilka razy padło to hasło, ale wystawiając receptę na dobrą analizę, trzeba raz jeszcze zwrócić na to uwagę. Z punktu widzenia całego procesu analitycznego jest to kluczowe. Pozornie małe odstępstwo od standardu związanego z dbałością o jakość danych może nieść za sobą gigantyczne konsekwencje. Osoba przygotowująca analizę, na każdym jej etapie powinna zachować niemalże aptekarską precyzję. Dbałość o detale w pracach związanych z przygotowaniem źródeł, ładowaniem danych, czyszczeniem bazy, czy efektywnym tworzeniem zapytań, jest niezwykle istotna i pozwala uniknąć wielu błędów w analizie.

Praca z biznesem. Duże firmy o rozbudowanej strukturze, często centralizują obszary związane z analityką. Wyodrębnione i odseparowane od biznesu jednostki koncentrują się na dostarczeniu zleconej analizy, często bazując jedynie na podstawowych wymaganiach bez wejścia w szczegóły. Dobry analityk niczym doktor powinien skrupulatnie przeprowadzić wywiad i zrozumieć potrzebę analityczną, tak aby zaplanować właściwie prace. W przypadkach trudnych np. gdzie budowane jest nowa hurtowania danych konieczna jest praca projektowa, gdzie w skład grupy projektowej wejdą wszystkie osoby, które będą pracować na tych danych. I choć z pozoru udział osoby, która fizycznie nie będzie pracować na nowym zbiorze, a jedynie będzie odbiorcą analizy może być uznana na mało istotną, to praktyka często pokazuje, że wiedza osób z „biznesu” jest kluczowa. Dzieję się tak, ponieważ to zleceniodawcy wiedzą co tak naprawdę wnoszą dane, jakie są zależności pomiędzy nimi i jaka jest ich wartość w procesie decyzyjnym. Ważne jest, aby układać ten proces szeroko i nie zamykać się w pracach jedynie na dostarczeniu podstawy projektu. W przypadku Big Data praktyka pokazuje, że zmiany w firmach zachodzą tak dynamicznie, że sztywne ograniczenie prac projektowych, wiązałoby się z dostarczeniem produktu (nowego źródła), które już na starcie może być niepełne lub mało wartościowe. W tym wypadku kluczowe jest elastyczne podejście do prac, mając zawsze na uwadze potrzebę biznesową.

Współpraca ze zleceniodawcą będzie istotna również w przypadku testów. Prace testowe należy wykonać bezwzględnie. Na tym etapie wychodzi bardzo wiele nieprawidłowości, a jakość danych i końcowa analityka musi być wolna od wszelkich błędów.

Dobre źródło to podstawa, ale liczy się również to jak te dane zostaną zaprezentowane. Kilkadziesiąt slajdów prezentacji naszpikowanych mało czytelnymi tabelami i widok niezadowolonego decydenta, który pomimo takiej ilości slajdów nie jest w stanie odpowiedzieć na pytanie, jaki jest powód zmiany wskaźnika, który go zainteresował, to już przeszłość. Teraz z pomocą przychodzą zaawansowane rozwiązania BI do wizualizacji danych (jak np. Tableau). Dzięki takim rozwiązaniom analityk w prosty sposób przygotuje czytelną prezentację, na podstawie której odbiorca będzie w stanie odpowiedzieć na wszelkie pytania. Dzieje się tak, ponieważ Tableau umożliwia drylowanie danych, gdzie z pozoru prosta prezentacja, która prezentuje podstawy KPI, staje się potężnym narzędziem analitycznym i w zależności od potrzeby decydent jest wstanie w kilku krokach wybrać interesujący go widok, poziom agregacji i w razie potrzeby dojść do źródła problemu analitycznego. W dzisiejszych czasach ważne jest tempo przy podejmowaniu decyzji. Smartfon jest podstawowym i często jedynym narzędziem pracy decydentów w dużych firmach. Tableau jest rozwiązaniem, które umożliwi pracę na danych za pomocą telefonu, a w przypadku wystąpienia takiej potrzeby decydent zostanie poinformowany o interesującej go zmianie.

Galopujące tempo zmian w biznesie, dyktuje nowe potrzeby analityczne. Duże firmy skarżą się na ciągły deficyt wiedzy i chcą obserwować nowe wskaźniki. Czy istnieje gotowa recepta na analityczny sukces? Pewnie nie, ale oprócz dbałości w układaniu procesu analitycznego, ważne jest aby inwestować w nowoczesne rozwiązania, które wspomagają biznes w szybkim i skutecznym podejmowaniu decyzji. Digitalizacja raportowania staje się podstawową potrzebą dużych firm. Codzienne raportowanie tych samych wskaźników musi odbywać się w sposób automatyczny. Sukces odniesie ten, kto szybciej uzyska wiedzę na temat zmiany, dostosuje się do niej i być może stanie się kreatorem nowych zmian.

Jeżeli chcesz zobacz film, gdzie zobaczysz, jakie trudności niesie za sobą proces przygotowania danych do analizy oraz jak sobie z nimi poradzić, zobacz nasze webinarium dostępne w wersji na żądanie, które znajdziesz poniżej.

cze 3, 2025

W tym artykule pokażę Ci, jak wygląda proces rozwoju oprogramowania z perspektywy współpracy z software house – od pierwszego szkicu...

maj 9, 2025

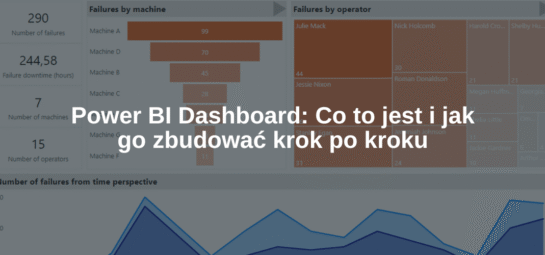

Power BI Dashboard to jedno z tych pojęć, które często padają w kontekście analizy danych i raportowania. Ale co to...

kwi 17, 2025

Oprogramowanie dedykowane to temat, który coraz częściej przewija się w rozmowach o rozwoju firm – nie tylko tych największych, ale...