cze 3, 2025

Rozwój oprogramowania – od pomysłu do gotowego produktu z software house

W tym artykule pokażę Ci, jak wygląda proces rozwoju oprogramowania z perspektywy współpracy z software house – od pierwszego szkicu...

sty 3, 2018

Współczesne bazy danych oraz pliki przechowujące informacje potrafią posiadać ogromne ilości rekordów. Ich analiza dała podstawy do rozwoju nowoczesnych gałęzi eksploracji danych typu Big Data oraz Data Science. W celu zapewnienia jak najlepszej jakości przechowywanych informacji przeprowadzana jest zazwyczaj procedura tzw. czyszczenia danych (ang. Data Cleansing) w której możemy wyróżnić cztery główne obszary działań:

W tym artykule zajmiemy się trzecim punktem przedstawionego procesu tzw. deduplikacją, przy czym przyjmujemy że poprzednie etapy oczyszczania danych mogły nie zostać przeprowadzone. Za przykładowy zbiór danych posłuż nam poniżej przedstawiona tabela (wczytywana w formacie csv) :

Pierwszym problemem będzie tzw. deduplikacja równościowa. Zakładamy w niej że wybrane przez nas pola muszą być identyczne by zaklasyfikować przykłady jako takie same. W powyższym przykładzie widzimy że rekordy o numerach 1 , 4, 6 przedstawiają tę samą informację, podobnie jak rekordy 2 i 7. W naszym przypadku wszystkie pola (poza Id z oczywistych względów) się pokrywają, jednak moglibyśmy sobie łatwo również wyobrazić sytuację w której wybieramy kilka pół kluczowych, po których rozpoznajemy że przykłady są różne (np: pole Dodatkowe informacje mogłoby być uznane za zbędne i nie rozróżniające przykładów). Przedstawimy teraz dwa, najprostsze sposoby radzenia sobie w takich sytuacjach. Pierwszym z nich jest wykorzystanie narzędzia Unique z pakietu Preparation.

Zaznaczmy w panelu wszystkie pola prócz Id jako unikalne. Narzędzie pod wyjściem U umieści wszystkie, pierwsze w kolejności, unikalne wystąpienia rekordów:

W efekcie na wyjściu U otrzymujemy :

Taki sam efekt możemy uzyskać grupując pola przy użyciu narzędzia Summarize z pakietu Transform :

Zajmiemy się teraz deduplikacją rozmytą (zwaną inaczej, nie do końca poprawnie probabilistyczną). Często zdarza się że pola choć mają inną formę zapisu między sobą, niosą tę samą informację. Klasycznym przykładem jest numer telefonu, mimo iż dla programu 536778093 oraz 536 778 093 są dwoma różnymi bytami, dla człowieka mają te samo znaczenie. W poniższej tabeli wprowadzone zostały przykładowe zmiany :

Możemy pominąć białe znaki używają np: narzędzia Data Cleansing z pakietu Preparation.

Zaznaczamy numer telefonu jako pole poddawane czyszczeniu, a następnie zaznaczamy opcję usunięcia wszystkich znaków białych :

Możemy teraz wykorzystać jeden z opisanych na początku sposobów do usuwania duplikatów. Narzędzie Data Cleansing umożliwia nam również wiele innych operacji np: zmianę wielkości wszystkich liter w danym polu, dzięki czemu możemy zniwelować różnice w formacie wprowadzonych danych.

Innymi narzędziami mogącymi nam pomóc w takiej sytuacji są Fuzzy Match i Make Group z pakietu Join. Fuzzy Match sprawdza jak bardzo rekordy są podobne między sobą według określonej metryki. Miarą tej pewności jest współczynnik Match Treshold ustawiony domyślnie na wartość 80 %. Za obiekt testów przyjmiemy tym razem pole Adres w którym wprowadzimy następujące zmiany :

Tworzymy przepływ danych :

W polu konfiguracyjnym wybieramy Purge Mode, do identyfikacji rekordów wybierzemy Id, zaś jako styl porównywania na polu Adres włączamy Address. W opcjach zaawansowanych u dołu panelu zaznaczamy Output Match Score oraz Output Generated Keys :

Widzimy że na poziomie pewności 100 % zostały połączone wszystkie rekordy które oczekiwaliśmy że będą ze sobą stowarzyszone. Możemy teraz wyznaczyć potrzebne nam Id używając narzędzia Make Group :

Make Group tworzy grupy uwzględniając zależności tranzytywnie przechodnie tzn: jeśli A jest w relacji z B i B jest w relacji z C to A jest też w relacji z C. Ponad to uwzględnia także to że element jest w relacji sam ze sobą. W efekcie otrzymujemy :

Można dzięki temu wykorzystać powstałe identyfikatory do deduplikacji danych.

cze 3, 2025

W tym artykule pokażę Ci, jak wygląda proces rozwoju oprogramowania z perspektywy współpracy z software house – od pierwszego szkicu...

maj 9, 2025

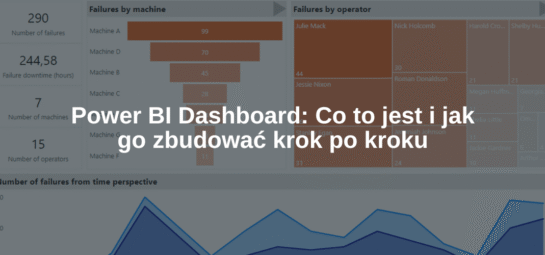

Power BI Dashboard to jedno z tych pojęć, które często padają w kontekście analizy danych i raportowania. Ale co to...

kwi 17, 2025

Oprogramowanie dedykowane to temat, który coraz częściej przewija się w rozmowach o rozwoju firm – nie tylko tych największych, ale...